O anúncio dos pesquisadores de inteligência artificial John Hopfield e Geoffrey Hinton como laureados do Prêmio Nobel de Física deste ano gerou comemoração e consternação sobre o status da IA na ciência e na sociedade. No Japão, no entanto, outro sentimento predomina: frustração.

“Pesquisadores japoneses também deveriam ter ganho”, proclamou um editorial do jornal Asahi Shimbun. Cumprimentando Hopfield and Hinton, a Sociedade Japonesa de Redes Neurais acrescentou: “Não devemos esquecer o papel desempenhado por pesquisadores japoneses pioneiros na construção das bases das pesquisas sobre redes neurais”.

As redes neurais estão no centro da IA contemporânea. Elas são modelos para que as máquinas aprendam de forma independente por meio de estruturas que, embora muitas vezes de forma superficial, são inspiradas no cérebro humano.

Então, quem são esses pesquisadores japoneses pioneiros em IA?

Em 1967, Shun’ichi Amari propôs um método de classificação adaptativa de padrões, que permite que as redes neurais autoajustem a maneira como categorizam padrões por meio da exposição a repetidos exemplos de treinamento. A pesquisa de Amari antecipou um método semelhante conhecido como “backpropagation”, uma das principais contribuições de Hinton para o campo.

Em 1972, Amari delineou um algoritmo de aprendizado (um conjunto de regras para executar uma determinada tarefa) que era matematicamente equivalente ao artigo de 1982 de Hopfield citado pelo Nobel sobre memória associativa, que permitia que as redes neurais reconhecessem padrões apesar de dados parciais ou corrompidos.

Os pesquisadores norte-americanos estavam trabalhando separadamente dos grupos no Japão, chegando a suas conclusões de forma independente.

Mais tarde, em 1979, Kunihiko Fukushima criou a primeira rede neural convolucional de múltiplas camadas do mundo. Essa tecnologia tem sido a espinha dorsal do recente boom da aprendizagem profunda (deep learning), uma abordagem de IA que deu origem a redes neurais que aprendem sem supervisão, por meio de arquiteturas mais complexas. Se o Nobel deste ano foi para “descobertas e invenções fundamentais que possibilitam o aprendizado de máquina com redes neurais artificiais”, por que não premiar Amari e Fukushima?

Perspectivas unilaterais

A própria comunidade de IA tem debatido essa questão. Há argumentos convincentes sobre por que Hopfield e Hinton se encaixam melhor na categoria “física” do Nobel e por que um equilíbrio nacional é importante, já que o Prêmio da Nobel da Paz foi para a Nihon Hidankyō (organização japonesa que luta contra as armas nucleares).

Por que, então, ainda devemos nos importar com isso?

A resposta está nos riscos da unilateralidade histórica. Nosso relato padrão sobre as redes neurais artificiais é uma história calcada no Atlântico Norte e, na maioria das vezes, na América do Norte. A IA passou por um período de rápido desenvolvimento nas décadas de 1950 e 1960.

Em 1970, entrou-se em um “inverno da IA”, durante o qual a pesquisa estagnou. Este “inverno” finalmente converteu-se em “primavera” na década de 1980, por meio de nomes como Hopfield e Hinton. Diz-se que os vínculos desse último pesquisador com a Google e a OpenAI contribuíram para o atual boom da IA baseada em redes neurais.

E, no entanto, foi exatamente durante esse suposto “inverno” que pesquisadores finlandeses, japoneses e ucranianos, entre outros, estabeleceram as bases da aprendizagem profunda. Integrar esses desenvolvimentos em nossas narrativas sobre a IA é essencial à medida que a sociedade enfrenta essa tecnologia transformadora. Precisamos expandir o que queremos dizer quando falamos de IA de maneiras diferentes da visão atual oferecida pelo Vale do Silício.

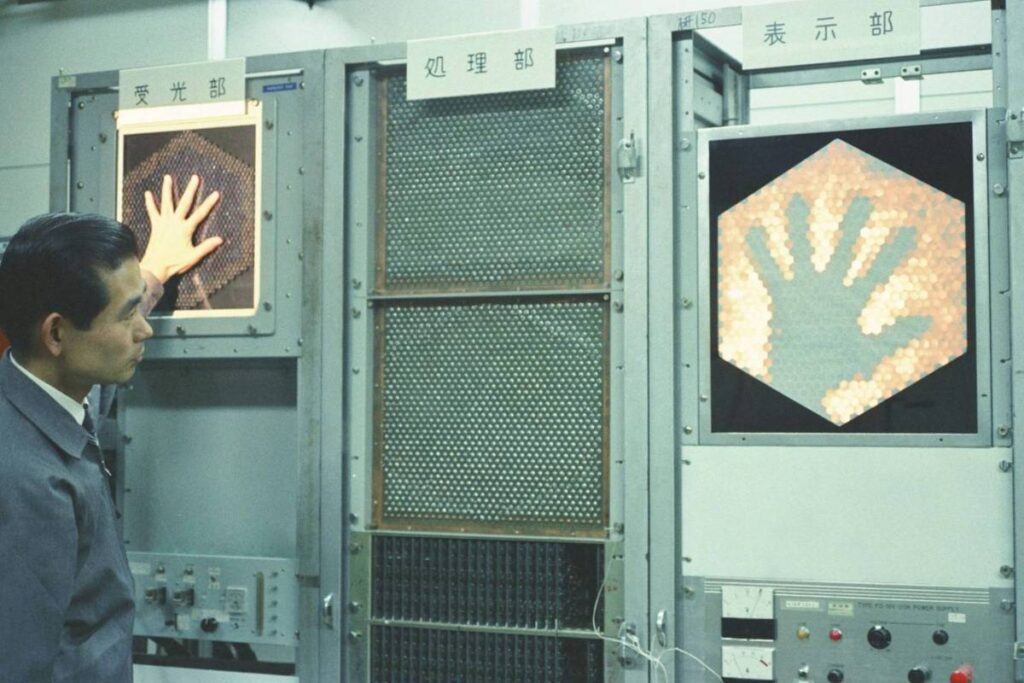

No ano passado, Yasuhiro Okazawa, da Universidade de Kyoto, Masahiro Maejima, do Museu Nacional de Natureza e Ciência de Tóquio, e eu conduzimos um projeto de história oral centrado em Kunihiko Fukushima e no laboratório na NHK onde ele desenvolveu o Neocognitron, um sistema de reconhecimento de padrões visuais que se tornou a base das redes neurais convolucionais.

A NHK é a emissora de TV pública do Japão, equivalente à BBC. Para nossa surpresa, descobrimos que o contexto sob o qual emergiu a pesquisa de Fukushima tinha raízes em estudos psicológicos e fisiológicos de audiências de televisão. Isso levou a NHK a criar, em 1965, um laboratório para a “biônica da visão“. Nesse laboratório, engenheiros de televisão poderiam contribuir para o avanço do conhecimento da psicologia e fisiologia (como os organismos vivos funcionam) humanas.

De fato, Fukushima via seu próprio trabalho como dedicado à compreensão de organismos biológicos em vez de IA no sentido estrito. As redes neurais foram concebidas como “simulações” de como o processamento de informações visuais pode funcionar no cérebro e foram pensadas para ajudar no avanço da pesquisa fisiológica. O Neocognitron visava especificamente ajudar a resolver debates sobre se estímulos sensoriais complexos correspondiam à ativação de um determinado neurônio (célula nervosa) no cérebro ou a um padrão de ativação distribuído em uma população de neurônios.

Abordagens humanas

O engenheiro Takayuki Itō, que trabalhou com Fukushima, caracterizou a abordagem de seu mentor como uma “ciência humana”. Mas, durante a década de 1960, os pesquisadores americanos abandonaram as redes neurais artificiais baseadas em modelos humanos. Eles se preocuparam mais com a aplicação de métodos estatísticos a grandes conjuntos de dados em vez do estudo paciente das complexidades do cérebro. Dessa forma, emular a cognição humana tornou-se apenas uma metáfora casual.

Quando Fukushima visitou os Estados Unidos em 1968, encontrou poucos pesquisadores que simpatizavam com sua abordagem de IA centrada no cérebro humano e muitos confundiram seu trabalho com “engenharia médica”. Sua falta de interesse em ampliar o Neocognitron com conjuntos de dados maiores acabou por colocá-lo em desacordo com a crescente demanda da NHK por tecnologias aplicadas baseadas em IA, o que levou a seu pedido de demissão em 1988.

Para Fukushima, o desenvolvimento de redes neurais nunca teve a ver com seu uso prático na sociedade como, por exemplo, a substituição do trabalho humano e a tomada de decisões. Em vez disso, elas representavam uma tentativa de compreender o que tornava vertebrados avançados como os seres humanos únicos e, dessa forma, tornar a engenharia mais humana.

De fato, como Takayuki Itō observou em uma de nossas entrevistas, essa abordagem de “ciência humana” pode se prestar a uma maior aceitação da diversidade. Embora o próprio Fukushima não tenha seguido esse caminho, o trabalho de Itō desde o final da década de 1990 tem se concentrado na “acessibilidade” em relação às características cognitivas de idosos e pessoas com necessidades especiais. Esse trabalho também reconhece tipos de inteligência diferentes da pesquisa de IA convencional.

Atualmente, Fukushima mantém uma certa distância do aprendizado de máquina. “Minha posição sempre foi aprender com o cérebro”, diz ele.

Em comparação com Fukushima, os pesquisadores de IA fora do Japão pegaram atalhos. Quanto mais a pesquisa convencional de IA deixa o cérebro humano para trás, mais ela produz tecnologias difíceis de entender e controlar. Sem suas raízes em processos biológicos, não podemos mais explicar por que a IA funciona e como ela toma decisões. Isso é conhecido como o problema da “caixa preta”.

O retorno a uma abordagem de “ciência humana” resolveria alguns desses problemas? Provavelmente não por si só, porque o gênio já saiu da lâmpada. Mas em meio às preocupações globais sobre uma IA superinteligente que resultaria no fim da humanidade, devemos considerar uma história global repleta de entendimentos alternativos da IA. Uma história que, infelizmente, não foi celebrada pelo Prêmio Nobel de Física deste ano.

Este artigo foi publicado no The Conversation Brasil e reproduzido aqui sob a licença Creative Commons. Clique aqui para ler a versão original